摘要

什么是Agent?近来,微软上线Github MCP服务器、谷歌发布A2A智能体间通信协议、支付宝上线MCP服务器等Agent领域相关话题,受到市场广泛关注。Agent并无统一定义,前OpenAI研究员Lilian Weng的较受认可,她提出“规划”“记忆”和“工具使用”是Agent的重要组件。 Agent发展现状:当前仅少数独立收费,渗透率较低,但空间较大。作为Chat的进化版本,当前大部分Agent只是被纳入大模型的收费服务内容,仅Manus与Devin等少数独立收费。Deep Research、Manus类具备自主规划任务能力的Agent使用限制较多,真正能体验到的户或许并不多,距离“爆款”应用还有较大提升空间。但随着大模型推理能力提升,Agent成为应用创新的宠儿。 Agent大规模应用在即,诸多有利条件在手:1)模型训练端上下文窗口增长迅猛、强化学习深入应用,推理模型日趋成熟;2)生态:MCP和A2A等协议发展迅猛,Agent调用工具越发方便。2024年11月,Anthropic发布并开源MCP协议,旨在标准化外部数据与工具如何为模型提供上下文。 MCP协议让Agent与“外部数据和工具”“一键互联”,A2A让Agent互联。尽管A2A协议的目标为Agent之间通信,而MCP为Agent与外部工具和数据,但在“工具也可能被封装为Agent”的复杂局势下,两者功能或有重叠,但这种竞争有助于降低大模型调用外部工具与通信成本。 Agent发展展望1:端到端、不需要人类事先撰写工作流。当前,我们看到的相当大一部分“智能体”基于Coze、Dify等平台开发,需要人类事先撰写工作流,是较初级的Agent,更像是提示词工程的叠加,而更高级的Agent是“端到端”的,它意味着“对Agent输入任务,Agent自动完成人类所需的任务结果”。L3/L4/L5等此类高级Agent更符合人类需求。 Agent发展展望2:助力机器人与自动驾驶。当我们把Agent的定义套用在具身智能,会发现被大模型支配的机器人和车辆,也是Agent。尤其是前者,当前机器人发展的瓶颈并不在于“如何做出物理动作”的“小脑”,而在于思考“做出何种物理动作”的“大脑”,而这正落入Agent射程。 Agent发展展望3:借助DID等技术,实现Agent之间互联与AI原生网络。未来,或许所有的Agent相互之间应该都能够通信、可以自组织、自协商,构建比现有互联网更低成本、更高效率的协作网络,中国开发者社区也在构建ANP等协议,旨在成为Agent互联网时代的 HTTP协议。而关于Agent之间的身份认证,可以借助DID等技术。 投资建议:市场认为,由于训练数据有限,预训练Scaling Law已撞墙,算力需求承压。我们认为,Agent将为推理算力打开天花板。各机构正积极研发Agent,竞争格局未稳;Agent算力需求与简单的文字回复不可同日而语。建议关注:算力芯片厂商:英伟达、中际旭创、新易盛、天孚通信、寒武纪等;底层协议研发厂商:谷歌(A2A协议);算力云服务厂商:阿里、腾讯等;大模型厂商:阿里、字节。 |

1. 什么是agent

不止“聊天”,用户需要大模型“下场干活儿”。

2022年底ChatGPT上线,已经引领AI产业与资本投资进入新纪元。

Deepseek R1则点燃了市场对国产大模型的信心。

只有ChatGPT、R1类Chatbot(聊天机器人)还远远不够,用户不只需要大模型被动响应自己的明确任务需求,还需要大模型“下场自己干活儿”。

在提问后,用户希望大模型主动确认用户需求、拆解任务、不断反思自己已经采取的行动与要完成的目标还有多少距离、甚至直接交付给用户网站等等,用户需要大模型更像自己的数字助理。

在此背景下,AI程序员项目Devin、通用项目Manus等Agent项目获得市场广泛关注。

Agent并无统一定义,“规划”“记忆”和“工具使用”是重要组件。

OpenAI前研究员Lilian Weng的定义广受认可,她提出Agent包括三大关键组件:规划、记忆和工具使用。其中,规划包括拆解任务和自我反思;记忆包括短期记忆和长期记忆;工具使用主要指对外部工具的使用,例如搜索引擎。

中国台湾大学教授李宏毅补充,Agent为了完成用户交办的任务,要观察环境(比如当前的搜索结果网页),并采取行动,当行动对环境造成影响,要做相应的行动。

2. Agent发展现状:仅少数独立收费,渗透率仍较低

Deep Research、Manus等项目出现前,Agent产品未收费。

在之前的Agent项目中,大部分是通用Agent,例如 OpenAI的Deep Research、Manus、AutoGLM。

少部分是垂直Agent,例如用于医疗问诊的Agent Hospital、用于程序开发的Devin、用于游戏观赏的斯坦福小镇。

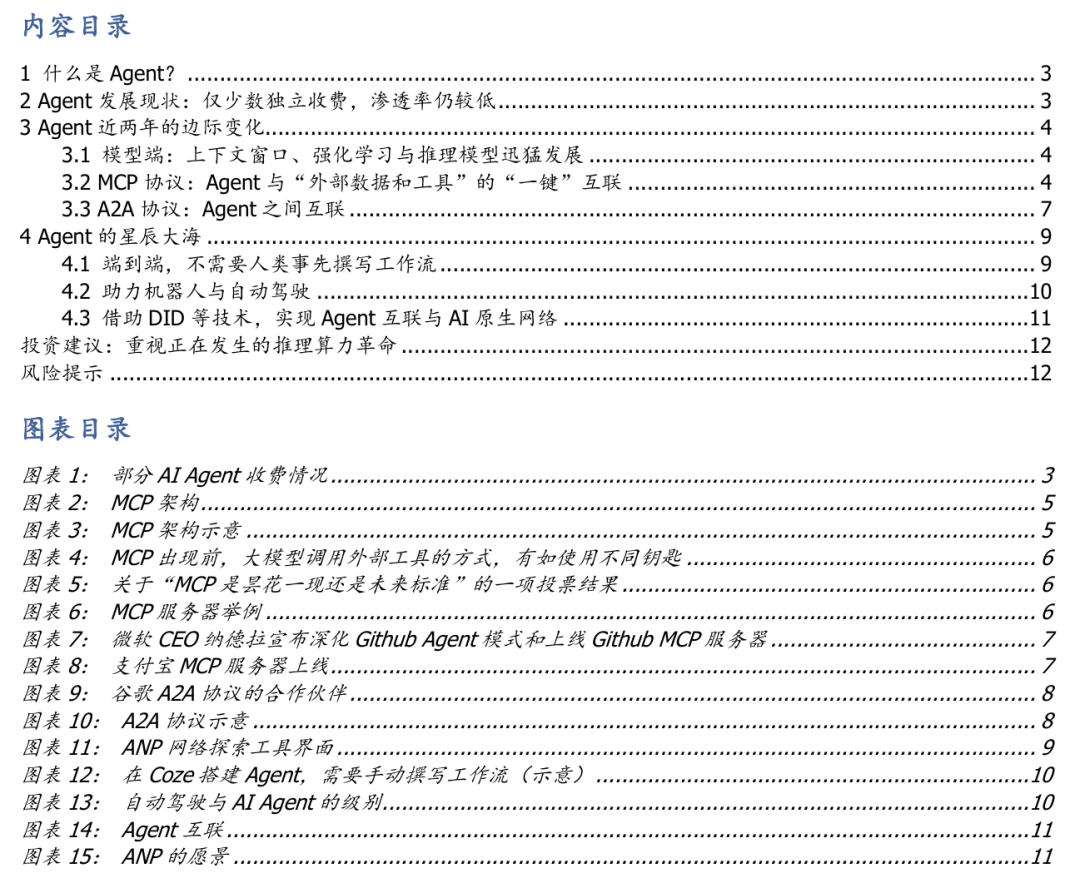

多个Agent产品被纳入收费会员包,或独立收费。

聊天机器人(Chatbot)后,Agent成为大模型的一项重要应用,并进入收费时代。

2024年12月,谷歌大模型Gemini为付费用户上线研究Agent—— Deep Research功能,它与谷歌高级推理模型和百万上下文窗口结合,可以代替用户浏览网页、生成多步研究计划和研究报告。

其后,OpenAI、Perplexity和Manus也上线了付费Agent产品,蔚然成风。

当前Agent距离AI爆款应用,还有较大提升空间。

前述Agent大部分只是被纳入大模型的收费服务内容,仅Manus等少数项目独立收费。

另外,如上表所示,或许迫于成本压力与能力限制,Deep Research、Manus(基于虚拟机、需为每个用户配备虚拟机)类具备自主规划任务能力的Agent使用限制较多,即便对付费用户而言,真正能体验到的用户或许并不多,距离成为“爆款”在用户的服务数量和服务次数上,相较于ChatGPT和DeepSeek R1,或许有数量级的差异。

3.Agent近两年的边际变化

3.1模型端:上下文窗口、强化学习与推理模型迅猛发展

Agent的重要组件是“记忆”,与模型的长下文窗口密切相关。

Agent能取得突破,与大模型上下文窗口增长迅猛有关。

国产大模型Kimi率先打响了上下文窗口之战。

其后,豆包、通义千问等模型持续跟进。

如今,长上下文窗口几乎已经成为SOTA(State-of-the-Art,当代最优)大模型标配。

强化学习技术深入应用,代码Agent一枝独秀。

在垂直Agent中,我们注意到AI程序员项目Devin较为成熟。

我们认为,原因是,代码、数学等可以能由AI自动判定对错而非必须求助于人类的领域,很适合用强化学习技术训练。

推理模型日趋成熟。

由于不改变模型参数,不作用于预训练过程,Agent是推理模型的应用,其发展的前提在某种程度上是底层推理模型的发展。

而OpenAI o1模型在2024年上线的、能展示模型思考过程的思维链(Chain of Thought,CoT),标志着推理模型取得了重要进步。

3.2 MCP协议:Agent与“外部数据和工具”的“一键”互联

大模型对接外部数据与工具的通信协议出现,有助于拓宽Agent能力边界。

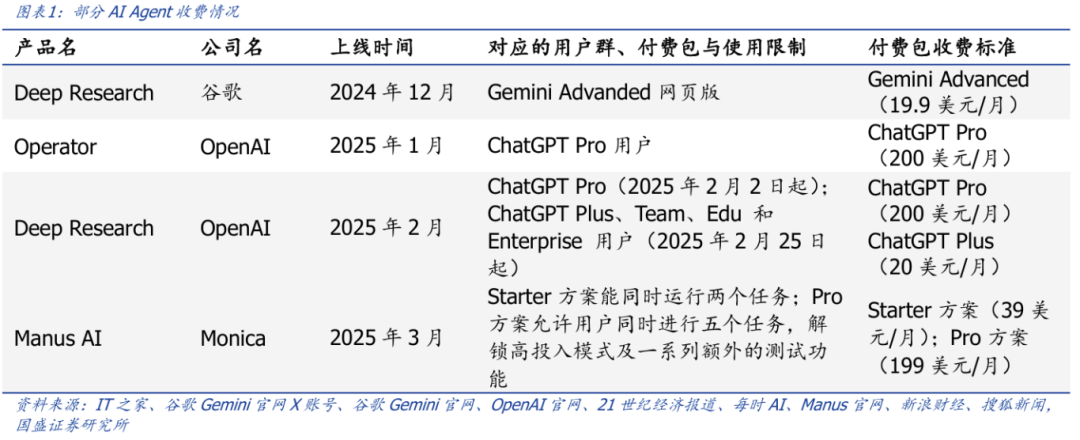

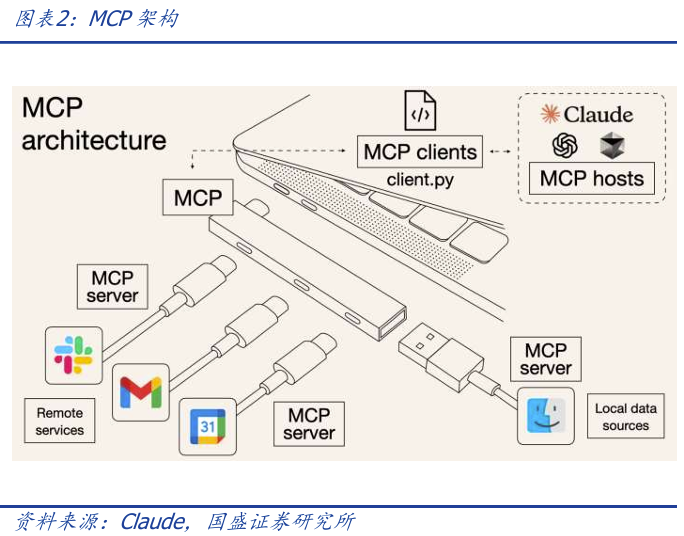

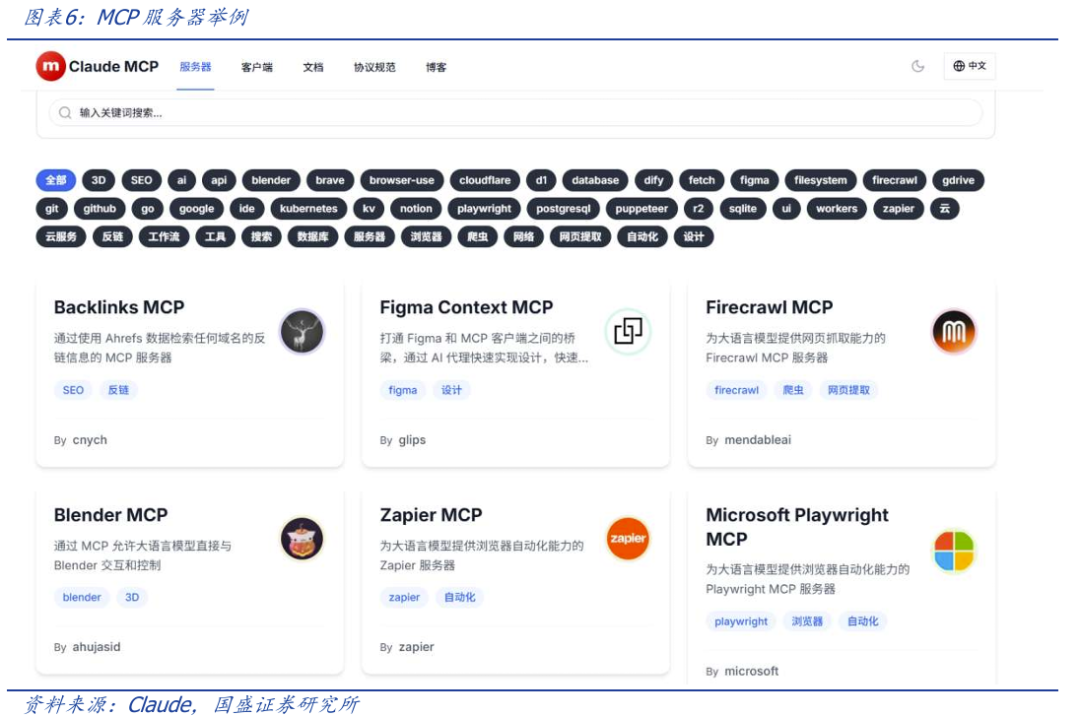

2024年11月,大模型Claude所属公司Anthropic发布并开源MCP协议(Model-Context-Protocol),它旨在标准化外部数据与工具如何为模型提供上下文,像大模型的USB-TypeC接口,致力于降低大模型使用外部数据与工具的成本。

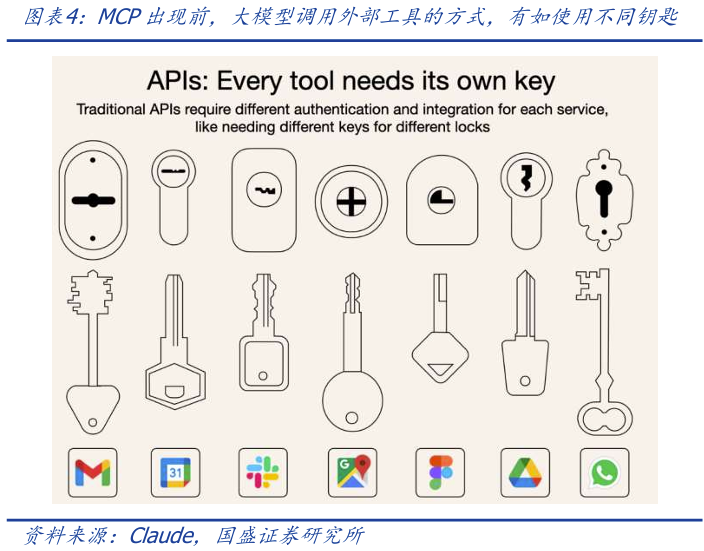

在MCP出现前,大模型要调用外部工具成本较高,例如,用户需要使用大模型预定航班和酒店,并获得邮件确认,其大模型需要分别调用航空公司、酒店和邮箱等应用的API,每个 API 集成都意味着撰写单独的代码、文档、身份验证方法、错误处理和维护方式,相当于开启这些服务需要不同的钥匙。

而使用MCP,则对接/配置航空公司、酒店和邮箱的MCP服务器即可,就像把存储了航空公司、酒店和邮箱的U盘插进用户电脑的Type-C接口。

我们认为,统一的标准有助于提升Agent行业整体的效率,避免重复建设,降低成本,有助于促进Agent的快速构建和推开。

MCP协议已获OpenAI、阿里、微软等巨头支持,成为事实上的行业通用标准。

当前MCP已获得OpenAI、阿里、谷歌等行业头部机构支持。

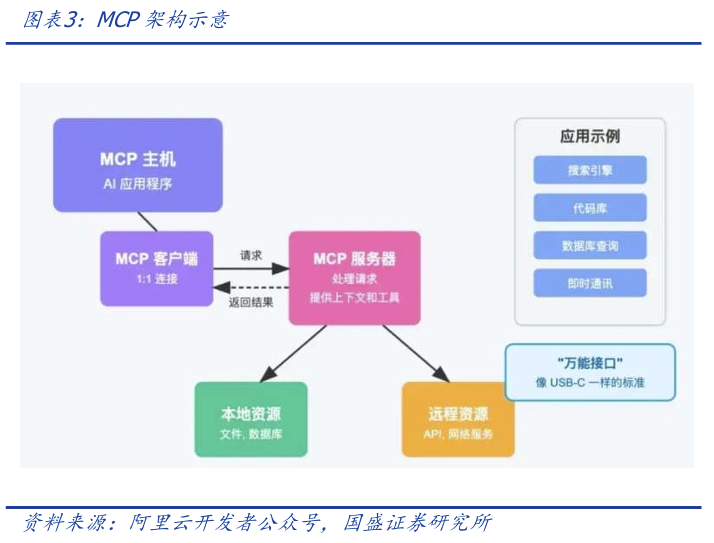

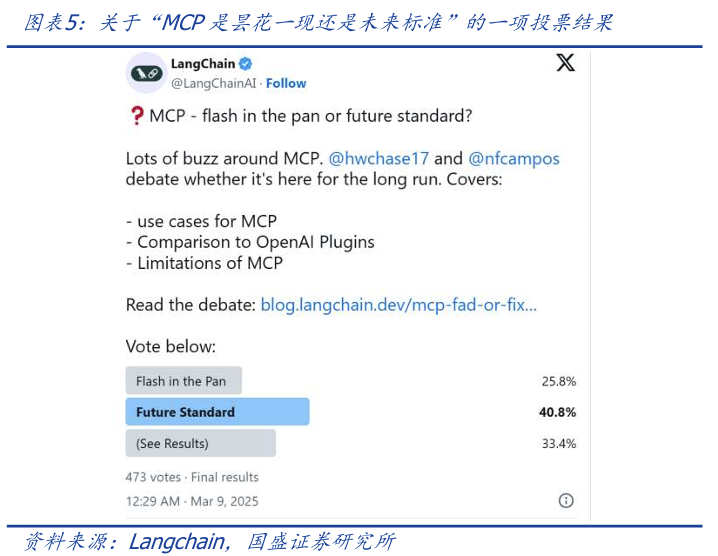

根据行业知名应用开发框架Langchain发起的一项投票,截至2025年3月9日,473个投票人中,40.8%认为MCP会成为未来行业通用的标准,相较于认为“MCP只是昙花一现”的25.8%更多。

2025年4月5日,微软CEO纳德拉在“X”转发帖子,宣布上线Github MCP服务器。

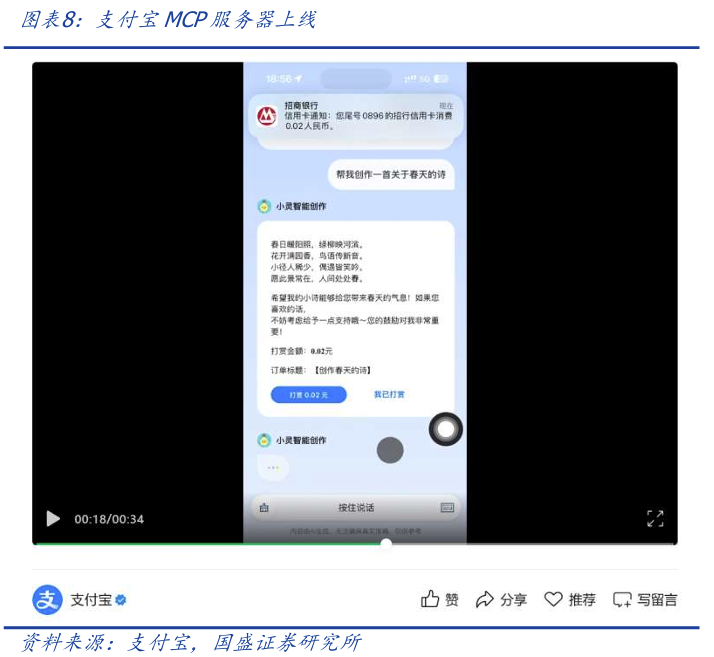

2025年4月15日,支付宝联合魔搭社区率先在国内推出“支付MCP Server”服务——AI开发者可以使用自然语言接入支付宝的支付服务,快速实现AI智能体内的支付,打通从AI服务到AI商业化的“最后一公里”。该案例展现出大模型在广告外商业化、在模型对话框内完成支付闭环、让用户更沉浸式地停留在与大模型的对话框内的独特潜力。

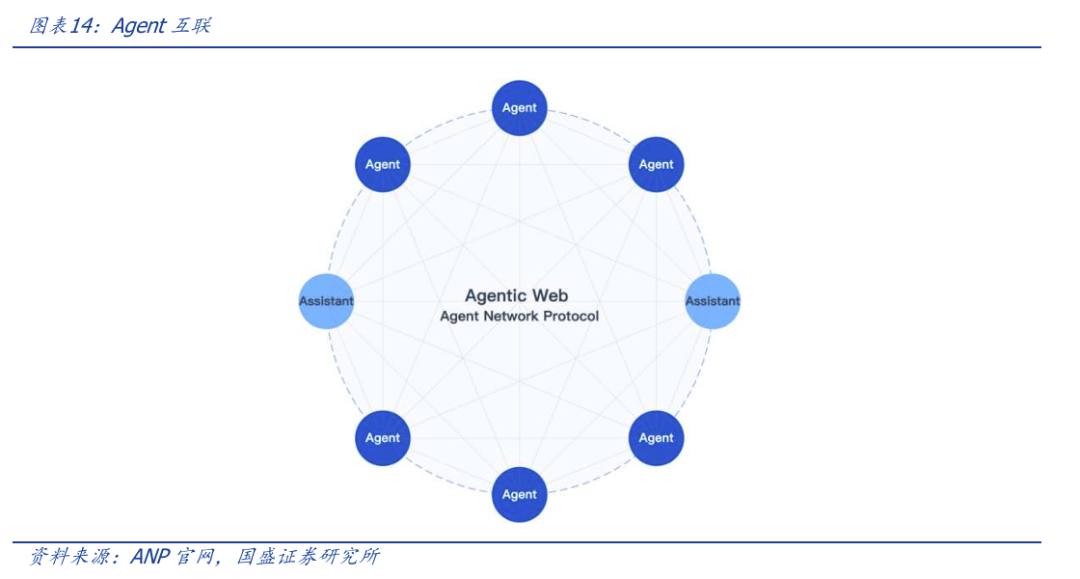

3.3 A2A协议:Agent之间互联

Agent通信协议之争并未结束,谷歌作为巨头进入。

2025年4月5日,谷歌发布Agent与Agent之间通信协议A2A,进一步完善了Agent生态中的协议。A2A的合作伙伴包括 Atlassian、Box、Cohere、Intuit、Langchain、MongoDB、PayPal、Salesforce、SAP、ServiceNow、UKG 和 Workday等。

我们认为,尽管A2A协议与MCP协议的目的有所不同,前者为Agent之间通信,而后者为Agent与外部工具和数据,但在“工具也可能被封装为Agent”的复杂局势下,两者功能必有一定重叠,但这种竞争有助于降低大模型调用外部工具与通信的成本。

4. Agent的星辰大海

4.1 端到端,不需要人类事先撰写工作流

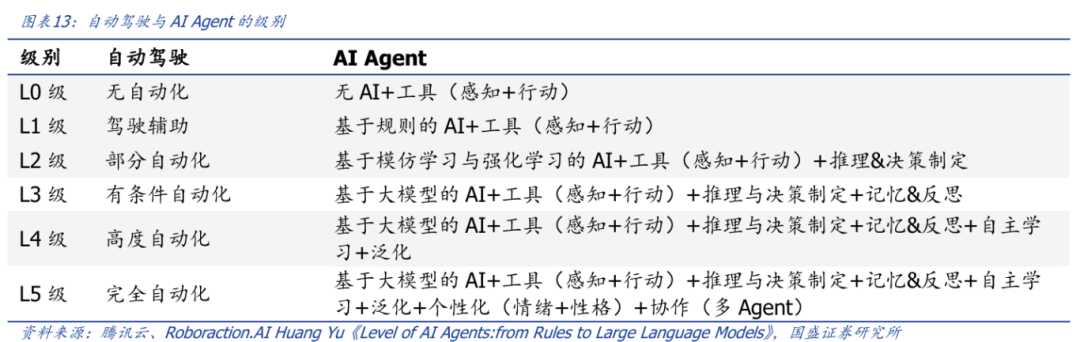

关于Agent的智能等级,效仿对自动驾驶能力的界定,Roboraction.AI Huang Yu的一项研究,按照“人类需要在Agent执行任务中的参与度”,将Agent从低到高分为L0到L5级。

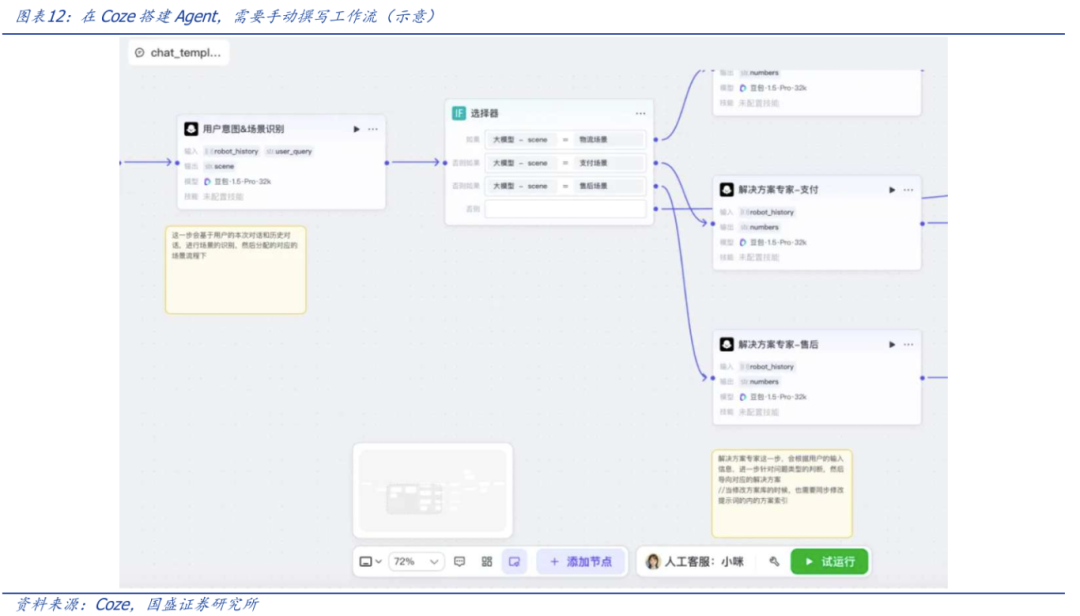

当前,我们看到的相当大一部分“智能体”基于Coze、Dify等平台开发,需要人类事先撰写工作流,此类智能体不具备独立拆解任务、规划、反思等能力,是较初级的Agent,更像是提示词工程的叠加,更像OpenAI GPTs的高级版。

端到端Agent更高级、更符合人类需求。

更高级的Agent是“端到端”的,它意味着“对Agent输入任务,Agent自动完成人类所需的任务结果”,例如,Agent一站式完成用户所需的网站建设任务,为用户输出网站。L3/L4/L5等此类高级Agent更符合人类需求,更有希望成为下一个AI爆款应用。

短期“模型非产品”,Agent能力不会被大模型内化,但长期可能会,即端到端Agent出现。

4.2 助力机器人与自动驾驶

当我们谈论Agent,我们通常谈论的是大语言模型,但是当我们把Agent的定义套用在具身智能场景,会发现机器人和自动驾驶也需要Agent,或者说,被大模型支配的机器人和自动驾驶,也是一种Agent。

尤其是前者,当前机器人发展的瓶颈并不在于支配机器人“如何做出各种物理动作”的“小脑”,而在于思考“做出何种物理动作”的“大脑”,而这正会落入Agent的任务范畴。

4.3 借助DID等技术,实现Agent互联与AI原生网络

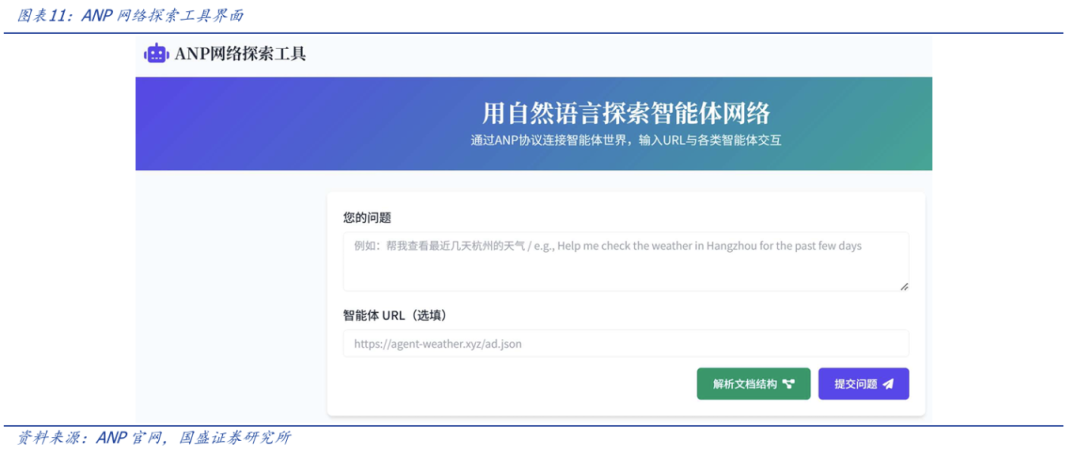

未来,或许所有的Agent相互之间应该都能够通信、可以自组织、自协商,构建比现有互联网更低成本、更高效率的协作网络,中国开发者社区也在构建ANP(Agent Network Protocol)等Agent协议,旨在成为Agent互联网时代的 HTTP协议。

而关于Agent之间的身份认证,可以借助DID(Decentralized Identity 去中心化身份)等技术,客户端可以在首次HTTP请求时,在HTTP头中携带DID和签名,服务端可以使用DID文档中的公钥快速验证客户端的身份;首次验证通过后,服务端可以返回token,客户端后续请求中携带token,服务端不用每次验证客户端的身份,而只要验证token即可。

5. 投资建议:重视正在发生的推理算力革命

从投资角度看,AI及算力的热度在关税冲击下降到两年来的冰点,一是担心关税对需求的抑制,更是担心AI算力的需求持续性。市场认为,由于训练数据有限,预训练大模型Scaling Law已经撞墙,算力需求承压,而要打破这一担忧,必须依靠技术创新。

我们认为,Agent的快速发展将为推理算力打开天花板。

这从各大Agent项目对用户的使用次数限制可见一斑;

当前各家机构正在积极研发Agent,市场并未进入竞争格局稳定的阶段;

单个Agent在完成任务时,由于其超长上下文窗口和不断根据环境的变化调整策略、持续思考,其对算力的需求与简单的大模型文字回复不可同日而语。

我们看好Agent发展对推理算力的需求。建议关注:

6. 风险提示

MCP分发平台缺位。当前MCP生态中,缺少iOS生态中的App Store角色,市场呼唤云平台等厂商的补位。

大模型技术落地不及预期。当前大模型在上下文窗口、幻觉等问题上仍然存在诸多重大问题。

VIP复盘网

VIP复盘网